Клиент обратился с просьбой убрать роботов из метрики, чтобы уменьшить коэффициент спамности сайта.

Сайт: Информационный, с картами метро, информацией о проезде и др.

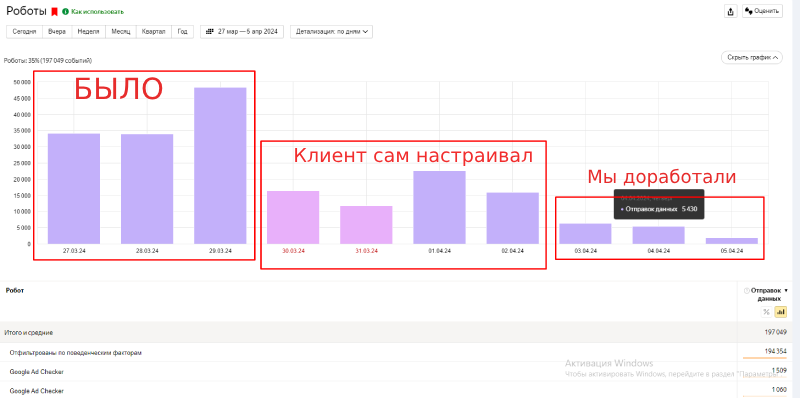

Было:

- Посещаемость: 15000 посетителей в сутки.

- Роботность: 40-50%

Стало:

- Роботность: 8-10%

- Посещаемость: 11000 посетителей в сутки.

После установки кода KillBot и проведения по работ по настройке фильтрации роботность в Яндекс Метрике упала до 8-9%. Были отфильтрованы исключительно роботы без оказания какого либо влияния на реальных пользователей.

Еще один скриншот с общей посещаемостью (с роботами по метрике):

Как такие результаты были получены?

- Была выбрана скрытая установка, так как блокировать доступ на сайт (даже ботам) цели нет. Цель - чтобы боты не попадали в метрику.:

- Скрипт установили и запустили с настройками по умолчанию: нужно собрать достаточно данных, чтобы далее их проанализировать.

- Через пару дней, когда данные собраны, мы начали анализировать поведение посетителей из каждой группы слепков. Основное внимание нужно уделить к слепкам, на которые приходится большинство трафика.

-

Для анализа поведения пользователей в слепке нажимаем на 'Вебвизор', и переходим в метрику для анализа поведения.

На рисунке ниже приведен пример поведения группы пользователей слепка "2149421682". Пользователи группы тупят на странице "404 Not Found" по минуте и переходят по тематически не связанным страницам: 'Ремонт обуви'->'Время работы метро'. Это признак бота. Так как такое поведение характерно для всех пользователей данной группы, то мы помечаем эту группу как "боты".

-

Внимание(!)

Нужно оценивать поведение массово: для всей группы заходов. Единичный заход можно расценить как бота, только если он кликает по невидимым ссылкам, оставляет фейковые заявки или скролит поверх попапа. - Для того, чтобы пометить слепок как "боты", сначала создадим группу, в которую будем добавлять слепки ботов:

Далее возвращаемся на страницу со слепками, и добавляем наш ботовский слепок в вновь созданную группу ботов "killbot", нажимаем на ссылку "В боты":

-

Далее следуем инструкциям (шагам) добавления бота в группу:

Здесь, обратите внимание, что внутри системы KillBot сделано так, что в группу ботов добавляется не само число-слепок, а именно сам визит со всеми параметрами, имеющий нужный нам слепок. Поэтому в форме добавления бота есть номер визита, который будет добавлен в группу, так же показывается номер слепка.

-

Нажимаем далее, и переходим к форме подтверждения:

ОБЯЗАТЕЛЬНО(!) прочитайте что написано на этой странице подтверждения. - По итогу анализа визитов, в слепках были выделены следующие группы ботов: 531371221, 841036149, 2726603771, 2149421682 - это самые крупные группы, на них приходится большинство трафика. Всех этих ботов мы поместили в вновь созданную группу ботов "killbot":

- Далее переходим в настройки и настраиваем скрипт так, чтобы ботами считались именно те визиты, слепки которых есть в нашей новой группе "killbot". Для этого ставим такие настройки:

С группы настоящих пользователей снимаем выделение - они нам не интересны. Выбираем нашу группу ботов "killbot", и помечаем, что "визит с неизвестным слепком" - это бот.

Настройки, выставленные таким образом говорят, что ботами мы считаем тех, чьи слепки заходов есть в группе "killbot", а всех остальных нужно считать настоящими пользователями.

Так же отключаем показ счетчика метрики для ботов:

Таким образом:

- Весь трафик сайта был разделён (кластеризован) на слепки. (Слепок нужно понимать как софт, с которого был выход в интернет.)

- В вебзизоре были проанализированы группы визитов, принадлежащие каждому слепку.

- По поведению были выделены слепки, визиты в которых принадлежат исключительно ботам.

- Фильтрацию трафика настроили так, чтобы игнорировались визиты, слепок которых совпадает слепком бота.

Как результат - роботность в метрике упала, как и спамность сайта.